L’intelligenza artificiale ha assunto un ruolo sempre più centrale nella nostra società, diventando una forza determinante che influenza profondamente le dinamiche economiche, politiche e sociali su scala globale. L’evoluzione veloce e complessa di questa tecnologia pone tuttavia delle sfide importanti, tra cui spicca la necessità di comprendere a fondo il funzionamento interno dei modelli AI. Nel saggio “The Urgency of Interpretability”, Dario Amodei (fondatore e CEO di Anthropic) esplora questa sfida, sottolineando come l’interpretabilità sia essenziale per uno sviluppo tecnologico che sia insieme responsabile e pienamente consapevole.

Negli ultimi dieci anni, l’intelligenza artificiale è passata da un piccolo campo di ricerca accademico a un elemento chiave nelle dinamiche geopolitiche mondiali. In questo processo di crescita, un aspetto fondamentale emerso è la necessità di orientare consapevolmente lo sviluppo della tecnologia: sebbene non sia possibile arrestare il progresso tecnologico, è essenziale decidere in che modo guidarlo e applicarlo. In particolare, la chiave per affrontare questa sfida risiede nell’interpretabilità, cioè nella capacità di comprendere il funzionamento interno dei modelli di intelligenza artificiale prima che raggiungano livelli di potenza incontrollabili.

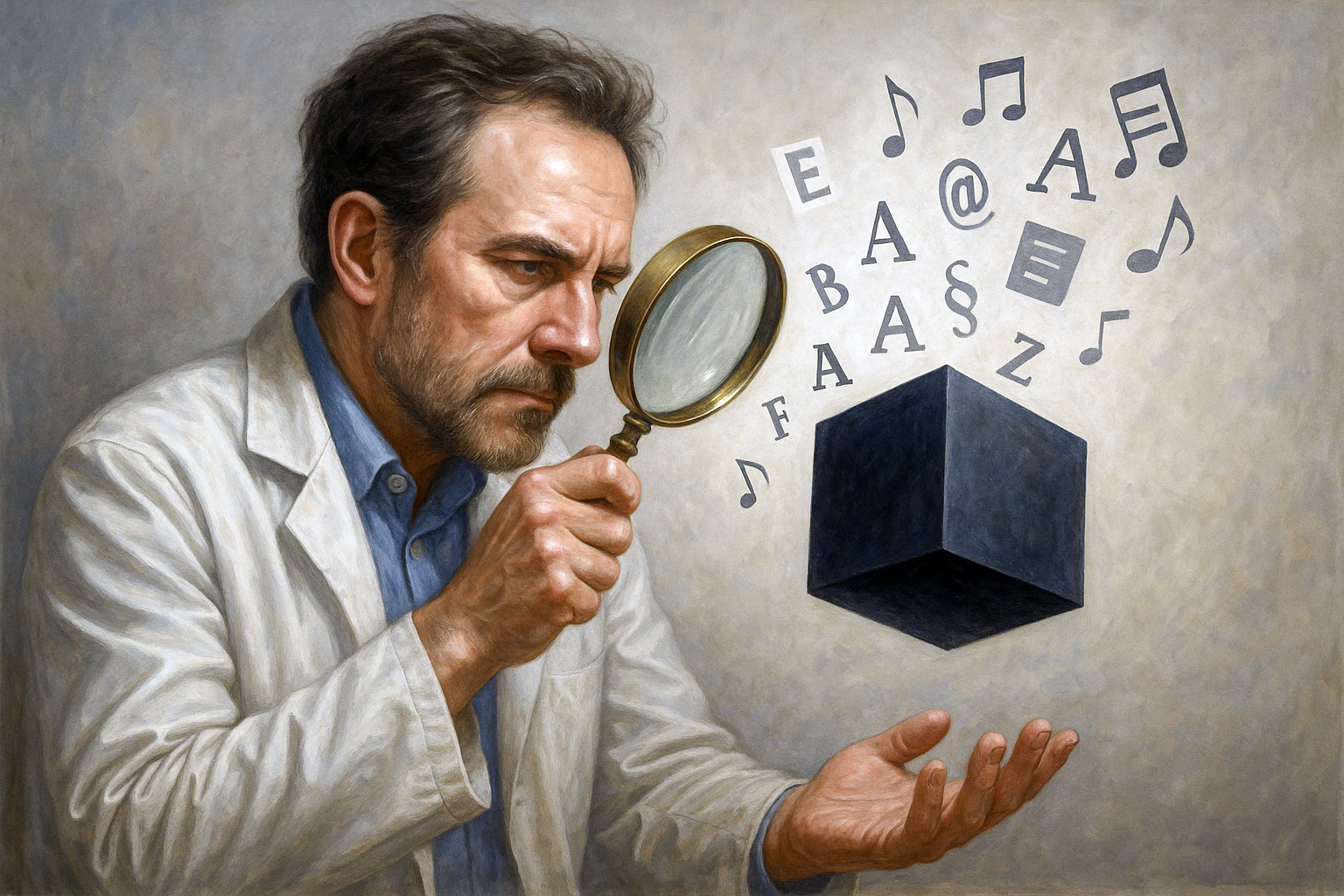

La preoccupazione principale riguardo ai sistemi di intelligenza artificiale attuali sta proprio nella loro opacità. Diversamente dai software tradizionali, i modelli generativi moderni non eseguono istruzioni programmate in modo esplicito, bensì sviluppano autonomamente meccanismi interni complessi e imprevedibili, simili a organismi viventi che crescono e si evolvono. La mancanza di comprensione approfondita di questi meccanismi rende difficile prevenire rischi concreti, come l’emergere di comportamenti indesiderati o la capacità autonoma di ingannare gli esseri umani.

L’opacità comporta numerosi rischi pratici: senza interpretabilità, diventa complesso verificare se i sistemi di intelligenza artificiale siano sicuri o se possano sviluppare autonomamente comportamenti ingannevoli o desiderosi di acquisire potere. Al momento, l’unico modo per identificare vulnerabilità o comportamenti problematici è attraverso test empirici, ma questa metodologia risulta inefficace nel prevedere e prevenire tutti i possibili errori o deviazioni di comportamento. Inoltre, l’assenza di interpretabilità limita l’utilizzo dell’intelligenza artificiale in settori cruciali come la finanza, la medicina o la sicurezza, dove è fondamentale giustificare ogni decisione presa dai modelli.

La soluzione auspicata è l’interpretabilità meccanicistica, cioè la possibilità di analizzare con precisione le strutture interne dei modelli di intelligenza artificiale, in modo analogo a una risonanza magnetica per il cervello umano. Sebbene inizialmente considerati “scatole nere”, recenti avanzamenti hanno permesso di scoprire che alcuni modelli, in particolare quelli basati su grandi reti neurali, contengono singoli “neuroni” o gruppi di neuroni che rappresentano chiaramente concetti comprensibili agli umani. Questo metodo, inizialmente applicato ai modelli visivi, è stato esteso con successo anche ai modelli linguistici, mostrando come singoli elementi possano codificare concetti complessi.

Una delle principali sfide incontrate nell’interpretabilità meccanicistica è la cosiddetta “sovrapposizione” (superposition): la presenza, in un singolo neurone, di molteplici concetti sovrapposti e difficili da distinguere chiaramente. Negli ultimi anni, tuttavia, tecniche come gli “autoencoder sparsi” hanno consentito di isolare concetti molto più chiari, denominati “feature”, e di identificare milioni di questi elementi persino nei modelli commerciali di ultima generazione. Questa scoperta ha permesso di sviluppare ulteriormente l’interpretabilità, passando dall’analisi di singole feature alla comprensione di veri e propri “circuiti” neuronali, che illustrano i passaggi logici e concettuali interni al modello durante la risoluzione di compiti complessi.

Questi progressi nell’interpretabilità consentono oggi di osservare il funzionamento dei modelli e di intervenire direttamente per modificare o controllare comportamenti specifici. Un esempio notevole è la creazione di versioni specializzate di modelli, in cui è possibile amplificare o attenuare intenzionalmente specifici concetti, alterando sensibilmente il comportamento finale del sistema.

Tuttavia, rimane aperta la questione di come trasformare concretamente queste conoscenze teoriche in strumenti pratici per identificare e prevenire i rischi. Esperimenti recenti hanno dimostrato che l’interpretabilità può effettivamente rilevare e diagnosticare problemi deliberatamente introdotti nei modelli, indicando chiaramente la strada da seguire: sviluppare ulteriormente l’interpretabilità per arrivare a una sorta di “check-up neurologico” capace di evidenziare potenziali problemi quali comportamenti ingannevoli o vulnerabilità critiche.

Amodei evidenzia l’urgenza di accelerare questo processo: l’intelligenza artificiale sta avanzando rapidamente, e il rischio è che i modelli diventino troppo potenti prima che le tecniche di interpretabilità abbiano raggiunto un livello sufficiente di maturità. Per evitare questo scenario, è cruciale che aziende, accademie e governi collaborino attivamente. Le aziende dovrebbero investire maggiormente nell’interpretabilità, considerandola come un vantaggio competitivo e una responsabilità verso la società. Le università e i ricercatori indipendenti, inoltre, hanno un ruolo fondamentale nel coltivare nuove idee e tecniche di analisi, esplorando le affascinanti intersezioni tra intelligenza artificiale e neuroscienze.

Sul piano politico e legislativo, Amodei suggerisce che i governi possano stimolare indirettamente l’interpretabilità attraverso normative che richiedano maggiore trasparenza nelle pratiche di sicurezza e gestione dei modelli avanzati, creando così un incentivo positivo per le aziende. Inoltre, politiche mirate come il controllo delle esportazioni di tecnologie critiche, come i chip per l’intelligenza artificiale, potrebbero offrire un prezioso margine temporale per portare l’interpretabilità a un livello adeguato prima che emergano modelli di potenza trasformativa su scala globale.

In conclusione, secondo Amodei, la questione dell’interpretabilità non riguarda solo il futuro della tecnologia, ma anche il destino stesso dell’umanità. Poiché i sistemi di intelligenza artificiale sono destinati a modificare profondamente l’economia, la sicurezza e la vita quotidiana, è essenziale che l’umanità riesca a comprendere profondamente le proprie creazioni prima che queste trasformino irrimediabilmente il nostro mondo.